Loi de Laplace-Gauss

Voici la plus connue et la plus utile des lois de probabilité théoriques. Curieusement dénommée loi normale (comme si les autres lois étaient des monstruosités), elle prend aussi le nom du génie Carl Friedrich Gauß (prononcez Gauss).

Mal nommée mais célèbre

Cette loi est la plus célèbre parce qu’elle modélise de nombreuses distributions statistiques observées.

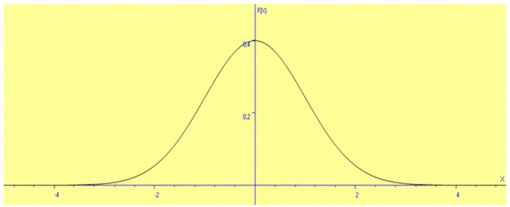

La représentation graphique de sa fonction de densité, continue et symétrique, a une forme très simple. C’est la fameuse courbe gaussienne (quoi qu'il aurait été plus honnête de la nommer « courbe de Moivre »), dite « en cloche » bien que la ressemblance avec une véritable cloche laisse à désirer.

Elle est aussi la plus utile parce qu’elle permet l’utilisation de très nombreuses techniques statistiques lorsqu’elle est vérifiée.

Cette célébrité lui valut d'être enseignée en terminale dans les années 2010. Si vous cherchez un petit complément d'information, des pages adaptées à ce niveau subsistent sur ce site : loi normale centrée réduite, intervalles associés à la loi normale centrée réduite, loi normale et calculatrices et loi normale avec geoGebra.

Présentation

La majorité des statisticiens ne connaissent pas l'expression de la fonction de densité de probabilité. Mais son absence sur cette page ne ferait pas sérieux. Alors…

\(f(x)\) \(=\) \(\displaystyle{\frac{1}{\sigma \sqrt{2 \pi}} \exp \left[-\frac{1}{2} \left(\frac{x-m}{\sigma} \right)^2 \right]}\)

\(m\) est l’espérance et \(\sigma\) (sigma) est l'écart-type. Si par exemple la variable aléatoire (v.a) \(X\) suit une loi normale d’espérance 10 et d’écart-type 1, on le note \(X \leadsto \scr{N}(0\,;1)\)

Ces deux paramètres suffisent pour résumer une distribution observée. Si l’écart-type est petit par rapport à l'espérance, la courbe de densité ressemble à une légère boursouflure et plus il s’en approche, plus la courbe s’étire en hauteur comme une fleur de datura. Mais il n’est pas pratique d’utiliser cette loi telle quelle pour les prolongements statistiques (intervalles de confiance, vérification d’hypothèses…). On se sert alors de la loi centrée et réduite, c’est-à-dire que l’on utilise une variable auxiliaire. C'est le principe du changement de variable : \(Z = \frac{X - m}{\sigma}.\)

On obtient alors une loi avec de nouveaux paramètres : l’espérance est nulle et l’écart-type est égal à 1. Retirer l’espérance consiste à CENTRER (par translation, la fonction de densité devient paire) et diviser par l’écart-type consiste à RÉDUIRE, c'est-à-dire à normaliser. Les valeurs prises par la fonction de densité de la loi centrée réduite sont indiquées dans des tables, du moins pour les valeurs positives.

L’expression de cette fonction centrée et réduite revêt une ligne plus épurée…

\(f(x)\) \(=\) \(\displaystyle{\frac{1}{\sqrt{2 \pi}} \exp \left( - \frac{x^2}{2} \right)}\)

La courbe de densité de probabilité apparaît ainsi (réalisée sur ZSGCalc) :

Elle est symétrique et l’essentiel des probabilités est contenu entre \(\pm 2\) écarts-types. Pour être plus exact, \(95\%\) des valeurs prises par la v.a se trouvent entre plus ou moins 1,96 écart-type autour de la moyenne. C’est cette valeur que l’on utilise le plus souvent pour déterminer des intervalles de confiance bilatéraux.

Plus l’échantillon est grand, plus la distribution de certaines lois, y compris discrètes, tendent à ressembler à celle de la loi normale (convergence en loi), notamment la loi hypergéométrique mais aussi la loi binomiale (théorème de Moivre-Laplace). L’utilité apparaît alors, entre autres, dans le cadre d’une comparaison de proportions. Une autre utilisation habituelle figure en page seuil de rentabilité probabilisé.

Nous avons vu que la distribution est symétrique. Cependant, une distribution asymétrique peut parfois être « normalisée » en utilisant les logarithmes ou les racines carrées.

Des tests d'adéquation permettent de s’assurer qu’une distribution est suffisamment proche de cette loi théorique pour bénéficier de ses nombreux avantages. Ce sont les tests de normalité, qui lui sont spécifiques, éventuellement ceux de Kolmogorov-Smirnov et du khi², ainsi que le test visuel de la droite de Henry.

Propriétés

La loi normale possède des propriétés bienfaisantes.

D’abord, elle est additive : si \(n\) v.a indépendantes suivent chacune une loi normale, leur somme en fait de même (contrairement à la loi uniforme, par exemple). Soit deux v.a indépendantes \(X_1\) et \(X_2\) qui suivent deux lois normales caractérisées par des espérances \(m_1\) et \(m_2\) et par des écarts-types \(σ_1\) et \(σ_2\) :

\(\displaystyle{(X_1 + X_2) \leadsto \scr{N} \left(m_1+m_2\,; \sqrt{\sigma_1^2 + \sigma_2^2} \right)}\)

Par ailleurs, la linéarisation d’une v.a \(X\) suivant une loi normale conduit également à une v.a \(Y = aX + b\) qui suit elle aussi une loi normale. C’est d’ailleurs cette propriété qui permet l'emploi de la version centrée réduite.

Théorème central-limite (TCL)

Cet indispensable théorème montre que les moyennes d'échantillons indépendants qui suivent une même loi de probabilité tendent vers une distribution normale pour peu qu'elles soient suffisamment nombreuses. C'est surtout cette propriété qui fait jouer à la loi normale un rôle central en statistique. Voir la page consacrée au TCL.

Régressions

En principe les résidus d’une régression simple ou multiple suivent une loi normale. Cette adéquation ne se visualise pas directement car, après avoir trié les résidus par ordre croissant, il faudrait les regrouper en classes et comparer l’histogramme avec une courbe de Gauss. Ceci manque un peu de rigueur. On utilise plutôt les tests de normalité ou la droite de Henry. Une non-normalité des résidus ne remet pas en cause l’équation du modèle mais elle empêche d’estimer les intervalles de confiance des paramètres. Précisons au passage que cette application fut celle que Gauss lui-même découvrit. Il nomma cette loi de probabilité la « loi de l'erreur ». Ce n'est que plusieurs décennies plus tard que l'astronome belge Quetelet fit le lien avec des distributions statistiques.

Exemples : voir les exercices corrigés sur la loi normale. Indispensable si vous n'avez pas tout compris ce qui est expliqué ici... Et pour une utilisation simple, rendez-vous sur les pages loi normale avec tableurs ou gestion des stocks et loi normale. En page d'inégalité de Bienaymé-Tchebychev vous trouverez les probabilités de se trouver dans quelques intervalles centrés autour de l'espérance.

Démonstration : voir la page des calculs de maximums de vraisemblance qui montre que la moyenne relevée sur un échantillon aléatoire est le meilleur estimateur de la moyenne sur la population.