Procédure de sélection de variables discriminantes

L’art de bien choisir ses ingrédients pour préparer une bonne cuisine.

Le plat du jour est l’analyse discriminante du chef. Celle-ci peut être préparée de deux façons. La première est l’AFD. Il s’agit de savoir si les modalités d’une variable qualitative sont liées à une certaine combinaison de valeurs de quelques variables quantitatives. La seconde façon est plus élaborée : l’analyse discriminante prédictive permet de plus ou moins bien deviner quelle modalité va prendre une nouvelle unité statistique qualifiée par ces mêmes variables quantitatives.

Les variables

Certaines variables sont discriminantes et d’autres non. Prenez les mensurations de plusieurs sportifs (mollets, cuisses, épaules…) et vous arriverez sûrement à deviner qui est cycliste, nageur, haltérophile… En revanche, les mensurations de la boîte crânienne ne seront certainement pas dicriminantes.

Donc, chaque unité statistique est classée selon un critère connu (client / non client, risqué / moyen / peu risqué, etc.) qui est la modalité d’une variable à expliquer qualitative. Par ailleurs, ces individus sont définis par des variables quantitatives candidates qui montrent éventuellement une liaison avec ledit critère. Exemple d’un scoring d’entreprises : la valeur prise par un ratio de rentabilité oriente le score sur la modalité « risquée » ou sur la modalité « peu risquée ».

Un choix soigné de variables candidates est donc nécessaire. Il s’effectue en deux temps. D’abord, et c’est l’objet de cette page, un examen individuel de chacune d’entre elles permet une première sélection. Celle-ci est bien entendu automatisée si des centaines de variables sont candidates. Ensuite, une deuxième sélection, cette fois multivariée, est opérée en fonction du type d’analyse, grâce à l’opportun secours du lambda de Wilks.

En principe, une étude préalable permet non seulement d’opérer un premier tri de variables mais aussi de choisir le type d’analyse le mieux adapté à leurs distributions (selon qu’elles sont normales ou non).

Conditions préalables

Les valeurs sont-elles distribuées normalement au sein de chaque groupe ? Des droites de Henry ou des tests de normalité de type Kolmogorov-Smirnov permettent de répondre à cette question cruciale. Même si les AFD sont assez robustes à la non-normalité, ces précautions peuvent aider l’analyste à choisir entre plusieurs variables un peu redondantes. Par ailleurs, la normalité autorise d’autres tests importants, notamment la vérification de l’homoscédasticité.

À titre d’exemple, une distribution qui ressemble à un dos de chameau n’est pas normale du tout (le dos du dromadaire est beaucoup plus conforme). Si lors d’une étude publicitaire on demande aux répondants combien d’émissions de téléréalité ils ont regardé la semaine précédente, il y aura beaucoup de zéros, peu de valeurs intermédiaires et les « mordus » collés à leur TV chaque fin d’après-midi. Dans ce cas, on se tourne vers une méthode adaptée (non linéaire), soit en conservant la variable quantitative, soit en découpant l’étendue des valeurs en classes pour la traiter comme si elle était qualitative. Ou mieux, on fait les deux et on retient la plus discriminante.

L’homoscédasticité (c’est-à-dire l’existence de dispersions semblables) est une condition importante de l’analyse discriminante. Un test de comparaisons de variances sur chaque variable s’impose si deux groupes sont à séparer ; s’il existe plus de deux groupes, on peut procéder aux tests de Levene et de Bartlett.

Pouvoir discriminant

Les hypothèses ci-dessus étant validées, la phase suivante de la procédure est théoriquement simple puisqu’elle nécessite des outils statistiques plutôt basiques.

Si deux groupes sont à séparer : tests de comparaisons de moyennes.

Si plusieurs groupes sont à séparer : ANOVA.

Les variables candidates dont les moyennes montrent une différence selon qu’elles appartiennent à un groupe ou à un autre sont qualifiées pour le second tour, à savoir une sélection pas à pas.

Voir un exemple des procédures mentionnées ci-dessus.

Résumé (exemple d’une analyse prédictive)

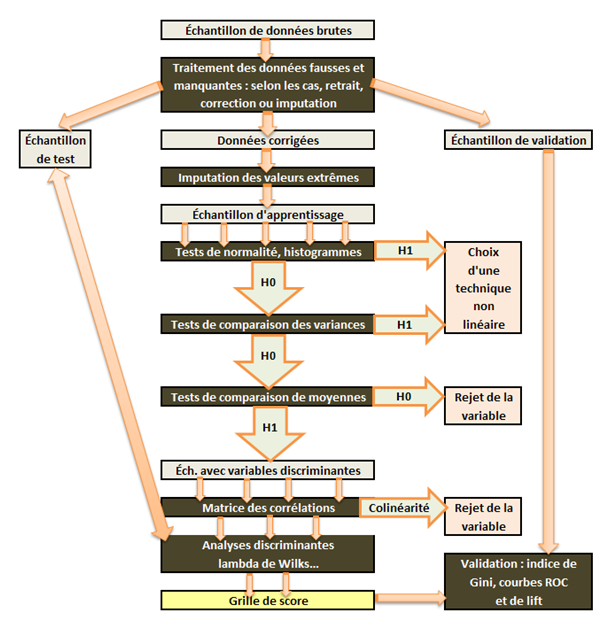

Le schéma ci-dessous est indicatif. On peut bien sûr l'adapter (examen des quantiles, détermination d’intervalles de confiance par bootstrap, par exemple). L’algorithme est plus ou moins automatisé en fonction du logiciel et du contrôle que l’on souhaite avoir sur les opérations.

Les premières étapes ont été omises. S’il s’agit d’un score d’octroi, elles incluent le redressement de l’échantillon par les dossiers refusés et la constitution d’un fichier « \(50\%\) bons » et « \(50\%\) dossiers douteux ».

En amont, la préparation des données a été scindée en deux parties : le traitement des valeurs manquantes et des données fausses est antérieur à la constitution des fichiers d’apprentissage et de test. L’imputation des valeurs extrêmes n’intervient qu’ensuite et seulement sur l’échantillon d’apprentissage.

Ce schéma ressemble suffisamment à une usine à gaz pour ne pas y ajouter les inévitables feedbacks, voire la confrontation avec une régression logistique ou un réseau de neurones… Si par exemple deux variables sont presque redondantes, il est normal de les inclure dans deux grilles candidates afin de comparer globalement leurs pouvoirs discriminants.