LFGN : présentation et démonstration

Vous avez peut-être entendu parler de LA loi des grands nombres (expression due à Poisson) mais savez-vous qu’il en existe deux, une forte et une faible ? Dénomination un peu curieuse, convenons-en. Intéressons-nous à la seconde qui n’est pas si faible que ça (d’ailleurs c’est surtout elle qui permet des applications pratiques).

Approche intuitive

Soit une grande maternité. Le premier bébé à naître cette année-là est un garçon. Statistiquement, on admet qu’il y avait une chance sur deux pour que ce soit le cas. On pourrait s’attendre à ce que le deuxième nouveau-né soit une fille. Mais l’année peut très bien commencer par une dizaine de naissances consécutives de garçons ! Toutefois, si l’on fait le point au 31 décembre et si des centaines de naissances ont eu lieu dans cette maternité, il y a de bonnes chances pour que l’on observe un certain équilibre entre les sexes des nouveau-nés.

Approche formelle

Soit une suite de variables aléatoires (v.a) indépendantes (comme le sexe des nouveau-nés, par exemple) \(X_1,\) \(X_2,\) \(…,\) \(X_n\) avec \(n \in \mathbb{N}.\)

On considère généralement qu’elles doivent être identiquement distribuées. En fait, elles ne suivent pas nécessairement la même loi de probabilité puisque les conditions de validité ne concernent que l'espérance et la variance ; mais dans cet exemple et la plupart du temps en pratique, elles la suivent.

L’espérance de chacune d’elles est \(m\) (nombre fini).

La variance de chaque v.a est elle aussi finie. Mais comme les v.a sont identiquement distribuées, si l’on en observe un nombre infiniment grand, alors leur variance est nulle.

\(\mathop {\lim }\limits_{n \to + \infty } V(X_n) = 0\)

Sous ces conditions, l’espérance de la suite de v.a \(X_i\) converge en probabilité vers \(m\) (ne s’agissant QUE d’une convergence en probabilité et non d’une convergence presque sûre, la loi est FAIBLE. Voici l’explication !).

Exprimé autrement, plus le nombre d’expériences aléatoires indépendantes augmente, plus élevée est la probabilité que la moyenne de nos valeurs observées soit proche de l’espérance théorique. Mais inutile de vous ruiner au jeu pour autant : si la roulette tombe quinze fois de suite sur PAIR, vous ne pouvez pas espérer qu’immédiatement après, une série de IMPAIRS viendra les compenser.

Remarque : cette loi est une conséquence de l’inégalité de Bienaymé-Tchebychev. Pourquoi ?

Démonstration

Soit une population décrite par une v.a \(X,\) de loi de probabilité quelconque. On tire aléatoirement un échantillon de taille \(n.\) Nous avons donc une suite de v.a : \(X_1,\) \(X_2,\) \(…,\) \(X_n.\) Chacune d’elles a pour espérance \(m\) et pour variance \(\sigma ^2.\)

Quelle est l’espérance des espérances ?

\(E(\overline{X}_n)\) \(=\) \(\displaystyle{\frac{1}{n} E \left(\sum\limits_{l = 1}^n {X_i}\right)} \) \(=\) \(\displaystyle{\frac{1}{n} \sum\ {E(X_i)}}\) \(=\) \(\frac{1}{n} (n \times m)\) \(=\) \(m\)

Quelle est la variance de ces espérances ?

\(V(\overline{X}_n)\) \(=\) \(\displaystyle{V \left( \frac{1}{n} \sum\limits_{l = 1}^n {X_i}\right)} \) \(=\) \(\displaystyle {\frac{1}{n^2} V \left( \sum {X_i} \right)}\)

Ceci en raison d’une propriété de la variance démontrée en page transformation affine d’une v.a. Donc :

\(V(\overline{X}_n)\) \(=\) \(\displaystyle {\frac{1}{n^2} \sum V({X_i})}\) \(=\) \(\displaystyle {\frac{1}{n^2} \times n \times V(X_i)}\) \(=\) \(\displaystyle{\frac{\sigma ^2}{n}}\)

Rappelons l’inégalité de Bienaymé-Tchebychev, où \(a\) est un réel positif.

\(P(|X - E(X)| \geqslant a) \leqslant \displaystyle{\frac{\sigma ^2}{a^2}}\)

Modifions deux éléments : nous remplaçons \(X\) par l’espérance de \(X_n\) (les deux membres de l’inégalité sont divisés par \(n\)) et nous renommons \(\varepsilon\) notre nombre \(a,\) ceci afin d'indiquer qu’il peut être choisi aussi petit que possible.

\(\displaystyle{P(|\overline{X}_n - E(\overline{X}_n)| > \varepsilon) < \frac{V(\overline{X}_n)}{\varepsilon ^2}}\)

En se servant des égalités précédentes…

\(\displaystyle{P(|\overline{X}_n - m| > \varepsilon) < \frac{\sigma^2}{n \varepsilon ^2}}\)

Dans le programme de terminale, cette inégalité est appelée inégalité de concentration.

Comme \(n\) est infini, la limite de cette probabilité tend vers 0.

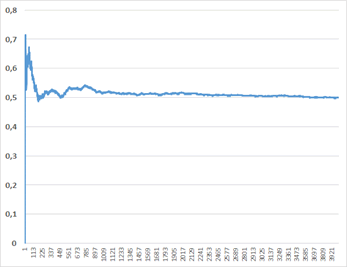

Illustration

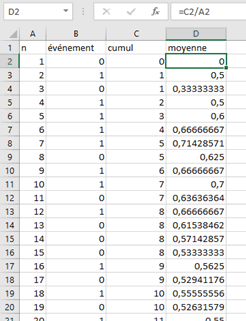

Il est facile d'illustrer la loi faible des grands nombres avec un tableur. Voici un mode d’emploi.

Nous prendrons l’exemple très simple d’un schéma de Bernoulli : une suite de v.a indépendantes qui n'acceptent que deux valeurs (en l’occurrence, avec équiprobabilité : de type pile ou face, ou de type fille ou garçon).

Ci-dessous, dans la deuxième colonne, un nombre 0 ou 1 a été généré de façon aléatoire avec la formule =ARRONDI(ALEA();0). Aucune difficulté pour créer les deux colonnes de droite.

Illustration sur les 4 000 premières observations. Il va de soi que si vous reproduisez cet exercice votre courbe sera différente, surtout pour les premières valeurs. Mais l’espérance du n-échantillon se stabilisera ensuite vers 0,5.