Généralités sur la photo numérique

Autrefois, le fait de faire développer ses photos avait un certain coût et prenait du temps. Aujourd’hui, une photo ne coûte rien, elle est visible à l’instant où elle est prise et son stockage est lui aussi presque gratuit.

Ce qui apparaît pour les particuliers comme l’un des principaux progrès technologiques du début de notre siècle a modifié d’innombrables pratiques dans la vie quotidienne. On prend une photo pour ne pas oublier un prix dans un magasin, pour apporter une preuve après un accident de la circulation, pour partager instantanément un souvenir de vacances, etc. Parallèlement, on peut s’inquiéter de certaines dérives : photos sur le web qui compromettent une réputation pour toujours, trucages indétectables, risques liés à la conservation (une photo a moins de risque de disparaître d’un album que d’un disque dur !) …

Historique

L’arrivée du numérique a été la plus grande révolution de l’histoire de la photographie depuis l’invention de la pellicule.

C’est en 1826 que Nicéphore Niepce fixe une image pour la première fois après une exposition de huit heures. Il meurt en 1833 sans avoir eu l’opportunité de tirer les bénéfices de son invention mais Daguerre, avec lequel il s’était associé, la perfectionne et accède à la notoriété. Les clichés obtenus par sa technique (une plaque d’argent sensibilisée aux vapeurs de mercure) sont appelés daguerréotypes.

Voici par exemple un daguerréotype du peintre Eugène Delacroix qui date de 1842 (Petit Palais, image libre de droits).

La première pellicule en Celluloïd est inventée en 1887. L’année suivante, le premier appareil photo populaire utilisant une pellicule, le Kodak, est mis au point et commercialisé par George Eastman. Les premiers procédés de photo couleur voient le jour dans les années 1890.

Le flash est inventé en 1928.

La photographie couleur instantanée est inventée par la société Polaroïd en 1972.

Le prototype du premier appareil photo numérique (APN) a vu au cours des années 70 dans une usine de Kodak. À l’époque, on ne voyait pas vraiment l’utilité de visionner des photos sur un écran de télévision et ce n’est qu’en 2001 que l’invention fut présentée au public. Mais les dirigeants de Kodak firent l’une des pires erreurs de jugement de l’histoire du management. Ne croyant pas à la photo numérique alors que c’est leur société qui l’avait inventée, ils ratèrent ce tournant essentiel et Kodak se fit dépasser par tous ses concurrents jusqu’à déposer le bilan en 2012. Depuis, la société s’est restructurée mais reste loin de ce qu’elle fut…

Dernier jalon important : le premier smartphone avec appareil photo intégré date de 2007.

Aujourd’hui, des milliards de photos sont prises quotidiennement. Parallèlement, les logiciels de retouche d'image se sont multipliés, offrant des fonctionnalités incomparables avec ce qui était réalisable à partir d’une photo argentique scannée (voir par exemple la page sur les niveaux de gris). Vous pouvez d'ailleurs programmer vous-même certains effets (voir la conversion en niveaux de gris avec Python, le seuillage ou encore l'extraction de contours).

L’image

Une photo numérique est composée de pixels, sortes de grains de couleur. Si la photo est de bonne qualité, l’œil humain ne les distingue pas car ils sont trop petits. Si la photo est de résolution très faible ou si on l’agrandit de façon extrême, alors ils sont bien visibles. On parle alors de pixellisation.

La résolution est la densité de pixels exprimée en dpi, c’est-à-dire en pixels par pouce.

La résolution d’un écran est de 72 dpi et celle d’une impression est le plus souvent de 300 dpi.

Ci-dessous, le bijou de l'auteur de ce site a été agrandi de façon à faire apparaître les pixels. Logiciel utilisé : Photoshop, à partir d’une image au format JPG.

![]()

Tout APN qui se respecte indique le nombre maximal de millions de pixels contenus dans une photo. Il offre aussi la possibilité de résolutions moins élevées, dont l’avantage est le gain de place sur la carte mémoire. À moins de prévoir des agrandissements, il est en effet inutile d’enregistrer des photos dont la résolution va au-delà de la vision humaine.

La profondeur de couleur est le nombre de bits utilisés pour un pixel.

Fonctionnement

Les capteurs des APN sont composés de photosites. Ce sont de minuscules capteurs de lumière, généralement carrés. Tous les APN n’ont pas des photosites de même taille. Ainsi, deux appareils qui affichent un même nombre de millions de pixels ne permettent pas toujours des qualités de photos identiques. Si le capteur est plus grand, la sensibilité est supérieure.

La définition d’une image est le nombre de pixels qui la composent multiplié par la taille. Soit par exemple un APN réglé au format 4/3 pour une image de \(1600 \times 1400\) pixels. Sa définition maximale est donc de \(1600 \times 1400\) \(=\) \(2,24\) mégapixels.

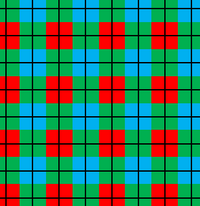

Grâce à un filtre, le photosite ne reçoit qu’une seule couleur. Avec le système RVB, un pixel la doit généralement à quatre photosites : un pour le rouge, un pour le bleu et deux pour le vert. Ce n’est pas pour autant qu’il y a quatre fois plus de photosites que de pixels puisqu’un photosite affecte les quatre pixels qui se trouvent autour. Ci-dessous, chaque pixel est délimité en noir et l’on voit qu’un photosite (carré de couleur) se répartit sur quatre pixels.

En pratique, le nombre de pixels est différent du nombre de photosites. Des algorithmes permettent de calculer les codes couleur de pixels à partir des pixels voisins.

Les capteurs comprennent aussi un filtre IR qui arrête les infrarouges et un filtre AA (anti aliasling) qui bloque les détails plus petits que les photosites. Celui-ci pourrait disparaître dans les années à venir.

Grâce au silicium du capteur, l’intensité lumineuse reçue par chaque photosite devient une tension électrique. Celle-ci est convertie en nombre puis en code binaire.

Algorithmes

Des algorithmes sont implantés dans les APN. Ils sont activés en fonction des modes choisis par l’utilisateur. Potentiellement très nombreux, il n’est pas possible d’en établir la liste et nous ne retiendrons que quelques exemples.

Lors de la prise de vue : les réglages automatiques activent des algorithmes de calcul d’exposition, de sensibilité, de vitesse d’obturation, de prise en rafale, de mise au point…

Lors de la transformation en image pixelisée : la balance des blancs est la correction de la couleur due à l’éclairage. Par exemple, une lumière apportée par un néon apparaît verte sur une photo, bien que l’œil ne s’en aperçoive pas. Ce défaut est corrigé par la balance des blancs. À l’époque de l’argentique, il fallait placer un filtre violet devant l’objectif pour neutraliser cette dominante. Mentionnons aussi la netteté, la modification de la luminosité et du contraste, etc.

En utilisant la fusion d’images : correction du bruit dû à une faible exposition (photos de nuit, par exemple), panoramas…